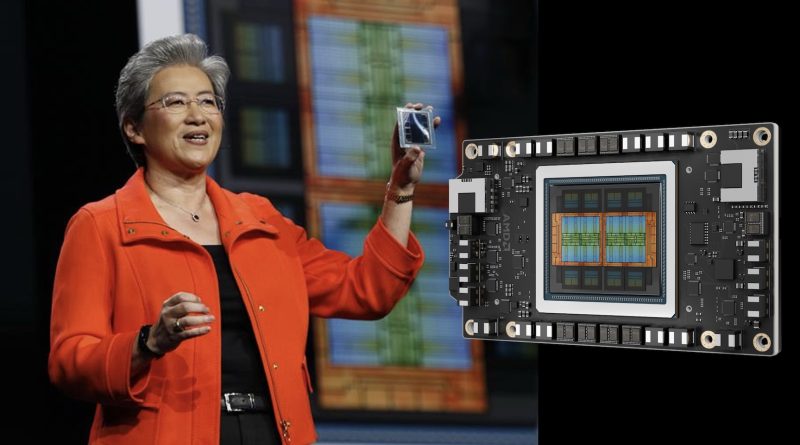

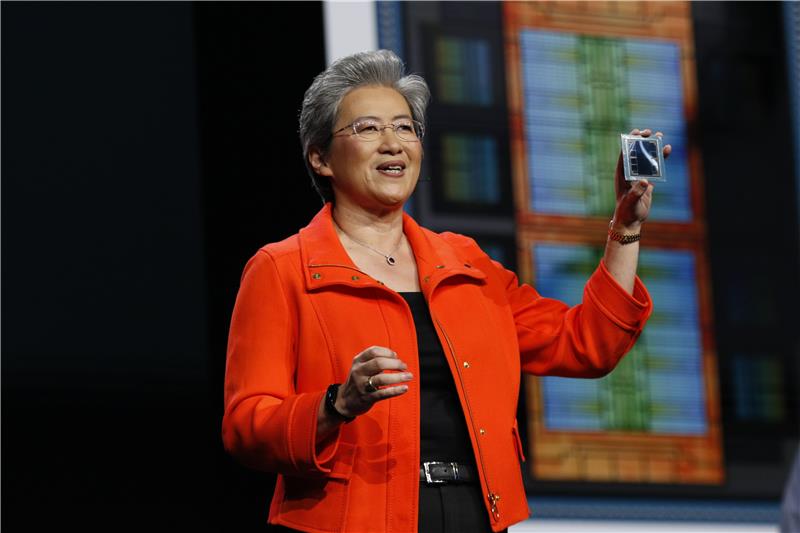

AMD公佈開放式AI生態 展示全新Instinct MI350系列加速器

AMD在美國舉行的Advancing AI 2025大會上公佈端對端整合式AI平台願景,並推出開放式、可擴展機架級AI基建。AMD董事長兼執行長蘇姿丰博士表示:「最新發布的AMD Instinct MI350系列加速器與新一代AMD 『Helios』機架級解決方案取得突破性的進展,而在ROCm開放軟件堆疊範疇的發展亦日益壯大,充分展現AMD在AI領域的卓越成果。」

蘇姿丰博士表示:「我們正邁進AI發展的新階段,其核心驅動力來自開放標準、共同創新,以及AMD在廣泛的硬件與軟件合作夥伴生態系統中不斷擴展的領導地位,共同塑造AI的未來。」大會上,Meta、OpenAI、xAI、Oracle、Microsoft、Cohere、HUMAIN、Red Hat、Astera Labs及Marvell等合作夥伴分享與AMD攜手推進AI解決方案的經驗。

加速開放式AI生態系統發展

AMD宣布推出涵蓋硬件、軟件及解決方案的廣泛產品組合,全面推動AI發展:

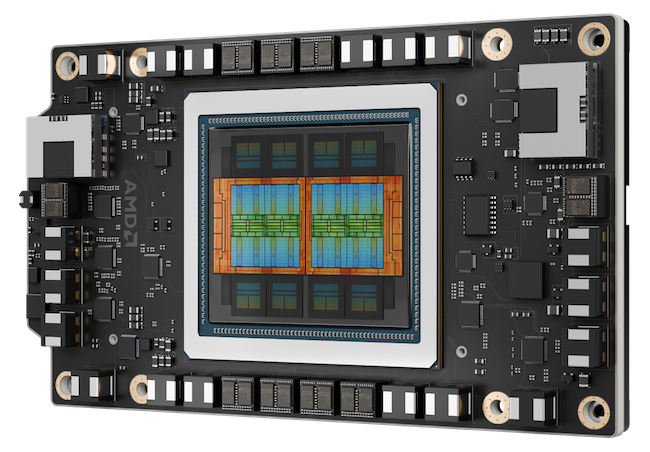

· AMD推出Instinct MI350系列GPU,為生成式AI及高效能運算樹立效能、效率及可擴展性的全新標準。MI350系列包含Instinct MI350X,以及MI355X GPU與平台,較上一代產品,帶來高達4倍的AI運算能力提升註1及35倍的推論能力升級註2,提供創新的AI解決方案,協助各行各業實現轉型。MI355X的性價比方面亦顯著提升,與競爭對手的解決方案相比,每美元可產生多達40%的Token註3。

· AMD展示端對端、具開放標準的機架級AI基建,配備AMD Instinct MI350系列加速器、第5代AMD EPYC處理器及AMD Pensando Pollara NIC,並已部署於Oracle Cloud Infrastructure (OCI) 等超大規模雲端供應商(hyperscaler)環境中,預計於2025年下半年全面推出。

· AMD亦預覽新一代AI機架「Helios」,將配備新一代AMD Instinct MI400系列GPU、「Zen 6」架構的AMD EPYC 「Venice」 CPU及AMD Pensando 「Vulcano」 NIC。相比上一代產品,AMD Instinct MI400系列GPU預計將混合專家模型上運行推理的效能提升高達10倍註4。

· 最新版本的AMD開源AI軟件堆疊ROCm 7,旨在應對生成式AI及高效能運算工作負載日益增長的需求,並同時全面提升開發人員體驗。ROCm 7具備更完善的業界標準框架支援、更廣泛的硬件兼容性,以及全新的開發工具、驅動程式、API及函式庫,以加快AI開發及部署。

· AMD致力將AI訓練及高效能運算節點的能源效率在5年間提升30倍,並在Instinct MI350系列中超越這項目標,最終實現高達38倍的顯著提升註5。AMD更公佈2030年的全新目標,與2024年相比,目標於2030年前將機架級能源效率提升20倍註6,令目前需要超過275個機架的經典AI模型,能在少於一個全面運用的機架中進行訓練,並同時減少95%的電力消耗註7。

· AMD亦宣佈推出AMD Developer Cloud,為廣泛的全球開發人員及開源群組,提供此專為快速、高效能AI開發而設的平台,讓用戶可存取全託管的雲端環境,備有所需工具及靈活性以啟動AI項目,實現無限增長。透過ROCm 7及AMD Developer Cloud,AMD正不斷讓更廣泛的用戶能夠使用新一代的運算效能,持續降低其使用門檻。與Hugging Face、OpenAI及Grok等相關領先企業開展策略性的合作,實現共同開發開放式解決方案的強大力量。

廣泛的合作夥伴生態系統展示AI進展

全球前十大模型構建商與AI公司中,已有七間在其生產工作負載中採用AMD Instinct加速器當中包括Meta、OpenAI、Microsoft及xAI等,於Advancing AI聯同AMD及其他合作夥伴,深入探討如何與AMD合作,利用AI解決方案訓練現時領先的AI模型、大規模能源推論,以及加快AI的探索與開發:

· Meta詳述如何廣泛部署Instinct MI300X於Llama 3及Llama 4推論。Meta對MI350的運算能力、每總體擁有成本(TCO)的效能表現,以及新一代記憶體均感到非常興奮。Meta將繼續與AMD緊密合作,推動計劃AI藍圖,包括Instinct MI400系列平台的相關計畫。

· OpenAI行政總裁Sam Altman闡述硬件、軟件與演算法全面優化的重要性,並強調OpenAI與AMD在AI基建方面的緊密合作,包括採用MI300X開發Azure研究及GPT模型,以及在MI400系列平台上的深度設計合作。

· Oracle Cloud Infrastructure (OCI)是首批配備AMD Instinct MI355X GPU的AMD開放式機架級AI基礎建設的業界領導者之一。OCI利用AMD CPU及GPU為AI叢集提供平衡、可擴展的效能,並宣布將推出由最新AMD Instinct處理器加快的Zettascale AI 叢集,備有高達131,072個MI355X GPU,協助客戶實現大規模的AI構建、訓練及推論。

· HUMAIN分享其與AMD簽訂的里程碑式協議,旨在利用AMD獨有的全方位運算平台,建立開放、可擴展、且具成本效益的AI基建。

· Microsoft宣佈Instinct MI300X現已為在Azure上支援專屬及開源模型的應用。

· Cohere指其高效能、可擴展的Command模型已於Instinct MI300X上部署,支援企業級LLM推論,實現高吞吐量、效率及數據私隱。

· Red Hat闡述其與AMD擴展的合作,如何實現可立即投入生產的AI環境,透過Red Hat OpenShift AI的AMD Instinct GPU,於混合雲中提供強大、高效率的AI處理。

· Astera Labs強調開放的UALink生態系統如何加快創新,為客戶帶來更大的價值,更分享有關UALink系列的發展計劃,何時提供全面的產品組合以支援新一代AI基建。

· 作為UALink聯盟的成員,Marvell與AMD攜手合作共同開發開放的互連技術,為AI基建帶來極致的靈活性。

註1:根據AMD效能實驗室於2025年5月的測試結果,使用FP16、FP8、FP6和FP4資料類型搭配矩陣運算,以確定8個AMD Instinct™ MI355X和MI350X GPU(平台)以及8個AMD Instinct MI325X、MI300X、MI250X和MI100 GPU(平台)的峰值理論精度效能。伺服器製造商的配置可能有所不同,從而產生不同的結果。結果可能因使用最新的驅動程式和最佳化而異。MI350-004

註2:基於AMD於2025年6月9日的內部測試結果。使用8個GPU的AMD Instinct™ MI355X平台,測量網上生成的文字,以服務Llama 3.1-405B聊天模型(FP4)的推論吞吐量,並與8個GPU的AMD Instinct™ MI300X平台的效能(FP8)進行比較。測試使用32768個token的輸入長度和1024個token的輸出長度,並將並行性設定為每個平台上可用的最佳吞吐量,以在每個平台上達到60毫秒,MI300X平台為1(35.3毫秒),MI355X平台為64毫秒(50.6毫秒)。伺服器製造商的配置可能有所不同,從而產生不同的結果。效能可能因使用最新的驅動程式和最佳化而異。MI350-044

註3:基於AMD實驗室截至2025年6月6日的效能測試結果,使用FP4數據類型搭配各種輸入、輸出token長度組合,在AMD Instinct™ MI355X 8x GPU上測量LLaMA 3.1-405B模型生成的文字推論吞吐量,並與NVIDIA B200 HGX 8xGPU的已發佈結果進行比較。每美元效能的計算方式是根據Coreweave網站上NVIDIA B200的現行價格以及預期的基於Instinct MI355X的雲端執行個體價格。伺服器製造商的配置可能有所不同,從而產生不同的結果。效能可能因使用最新的驅動程式和最佳化而異。目前的客戶價格截至2025年6月10日,可能隨時變更。MI350-049

註4:截至2025年6月5日的效能預測,基於未來AMD Instinct MI400系列GPU的設計,使用工程估算值與Instinct MI355x進行比較,採用2K和16K預填充搭配TP8、EP8以及預測的推論效能,並使用以GEMM和Attention演算法評估Instinct MI400系列的GenAI訓練模型。產品推出市場後的實際結果可能有所不同。MI400-001

註5:此計算包含1) Koomey Analytics於2025年根據現有研究和數據進行的基準案例千瓦時使用量預測,其中包含特定區塊預計的2025年部署量和數據中心電源使用效率(PUE),包括GPU HPC和機器學習(ML)安裝量,以及2) AMD CPU和GPU節點功耗,其中納入特定區塊的使用率(活動與閒置)百分比,並乘以PUE以確定實際總能源使用量,用於計算每瓦效能。38倍是使用以下公式計算得出的:(2025年基準案例HPC節點千瓦時使用量預測 * AMD 2025 年使用DGEMM和TEC的每瓦效能改進 + 2025年基準案例ML節點千瓦時使用量預測 * AMD 2025年使用ML數學和TEC的每瓦效能改進) / (2025年基準案例預測的千瓦時使用量)。更多資訊請參閱https://www.amd.com/en/corporate/corporate-responsibility/data-center-sustainability.html。EPYC-030a

註6:基於AMD藍圖,推估每年(2024年至2030年)用於AI訓練/推論的AMD先進機架,同時檢視歷史趨勢,以提供機架設計選擇和技術改進的資訊,使預測目標與歷史趨勢一致。2024年的機架基於 MI300X節點,與Nvidia H100相當,並反映了2024/2025年期間AI部署的現行常見做法。2030年的機架基於該時間範圍內AMD系統和晶片設計的預期。在每種情況下,AMD都指定了GPU、CPU、DRAM、儲存裝置、散熱和通訊等元件,並追蹤元件和定義的機架特性,以了解功耗和效能。計算不包括用於機架外部冷卻空氣或供水的功耗,但包括機架內部風扇和泵的功耗。效能改進的估計值基於運算輸出(交付的持續FLOPS,而非峰值FLOPS)、記憶體(HBM)頻寬和網絡(擴展)頻寬的進展,以指數表示,並由以下訓練和推論因素加權。

FLOPS HBM BW 向上擴展BW

訓練 70.0% 10.0% 20.0%

推論 45.0% 32.5% 22.5%

每個機架的效能和功耗共同暗示了訓練和推論隨時間推移的每瓦效能趨勢,然後以50:50的權重加權訓練和推論進展的指數,以得出AMD預計到2030年進展(20倍)的最終估計值。效能數據假設AI模型在利用低精度數學格式進行訓練和推論方面持續進步,這會導致有效FLOPS增加,以及每個FLOP所需的頻寬減少。

註7:AMD根據EPOCH AI數據(https://epoch.ai)估計訓練典型重要AI模型所需的機架數量。在此計算中,我們基於這些數據假設,一個典型模型需要10的25次方浮點運算來訓練(基於2025年數據的中位數),並且此訓練過程需要一個月時間。所需的FLOPs = 10^25 FLOPs / (秒/月) /模型FLOPs使用率(MFU)= 10^25 / (2.6298*10^6) / 0.6。機架數量=所需FLOPs / (2024年和2030年每個機架的FLOPS)。根據AMD藍圖的運算效能估計值,在2025年使用MI300X產品(假設每個機架22.656 PFLOPS,MFU為60%),大約需要276個機架才能在一個月內訓練一個典型模型,而在2030年使用基於AMD藍圖預測的機架配置,訓練相同模型則需要不到1個完全使用的機架。這些計算意味著在這6年期間,訓練相同模型所需的機架數量減少了276倍以上。使用MI300X系統以2024年的機架完全訓練一個已定義的2025年AI模型的用電量經計算約為7 GWh,而未來的2030年AMD系統可以使用約350 MWh訓練相同模型,減少了95%。然後,AMD應用了國際能源署2024年世界能源展望(https://www.iea.org/reports/world-energy-outlook-2024)中每千瓦時的碳強度。IEA提出的政策案例提供了2023年和2030年的碳強度。我們確定了從2023年到2030年強度的年平均變化,並將其應用於2023年的強度,以得出2024年的強度(434 CO2克/千瓦時)與2030年的強度(312 CO2克/千瓦時)。2024年基準情境的排放量為7 GWh x 434 CO2克/千瓦時,約等於3000公噸二氧化碳,而未來的2030年情境為350 MWh x 312 CO2克/千瓦時,約等於100公噸二氧化碳。